Во всем мире стремительно растут плотность и мощность оборудования в центрах обработки данных (ЦОД). По прогнозам IDC, к 2009 г. количество используемых в США серверов увеличится впятеро, в связи с чем ожидается настоящий бум строительства ЦОД. Впрочем, спрос на более совершенные центры данных является общемировой тенденцией. Компании, до последнего времени откладывавшие модернизацию инфраструктуры ИТ, вынуждены приступить к ее обновлению, дабы соответствовать требованиям новых технологий. Согласно опросу Network World, до 2012 г. ежегодный рост бюджетов ИТ составит 10-12%, из них 50-75% будет приходиться на ЦОД.

В России более актуальна тема строительства новых ЦОД. Системные интеграторы постепенно накапливают опыт в реализации таких проектов для различных заказчиков — от провайдеров услуг Internet до банков и государственных структур. В июне «Журнал сетевых решений/LAN» и агентство корпоративных коммуникаций OSP-Con провели первую конференцию «Какой должна быть инфраструктура современного центра обработки данных?», посвященную вопросам построения и эксплуатации инженерной инфраструктуры ЦОД, включая основные тенденции в области проектирования центров данных. Поставщики оборудования представили свои продукты и решения, а интеграторы поделились практическими наработками создания инфраструктуры ЦОД.

Консолидация ресурсов и приложений вкупе с изменениями в серверном парке центров данных диктует новые требования и подходы к реализации инженерных систем. Хотя заказчики решают разные задачи и запросы их весьма отличаются (например, в отношении отказоустойчивости и гибкости инфраструктуры ЦОД), накапливаемый опыт дает возможность создавать тиражируемые решения и реализовывать проекты с меньшими затратами.

Как отмечалось на конференции, все большую важность приобретает выработка единого подхода к организации ЦОД. Стандартизация должна способствовать консолидации инфраструктуры, уменьшению ее сложности и сокращению затрат, повышению управляемости, соответствию требованиям бизнес-процессов. Cтандарты обобщают опыт, накопленный в ходе построения и эксплуатации различных центров данных и серверных помещений, стимулируют системный подход к реализации инфраструктуры и тем самым к тиражируемости и масштабируемости решений, помогают унифицировать реализацию взаимосвязанных инфраструктурных систем и упростить внесение изменений.

В настоящее время проектировщики руководствуются американским стандартом EIA/TIA-942 («Стандарт на телекоммуникационную инфраструктуру центров обработки данных»), близок к завершению его европейский аналог EN 50173-5, на основе которого формируется и российский ГОСТ. Эти стандарты определяют, какие факторы следует учитывать при планировании и подготовке монтажа ЦОД или серверной, включая архитектурный проект, электроснабжение, заземление, другую инженерную инфраструктуру. Особенно актуальной тема стандартизации ЦОД стала в последние два года. Стандарты ЦОД специфицируют более десятка взаимосвязанных подсистем, что позволяет выработать единый подход к реализации инженерной инфраструктуры и снизить число ошибок.

Стандарт TIA определяет ЦОД как здание или его часть, предназначенные прежде всего для размещения оборудования обработки и хранения данных, функционирование которых обеспечивается вспомогательными системами. В России под ЦОД редко отводят отдельные строения. Часто помещения выделяются «по остаточному принципу», из-за чего приходится применять сложные и подчас очень дорогие решения для создания требуемых «климатических условий», чтобы оборудование работало нормально. В стандарте TIA-942 впервые обобщены требования к помещениям ЦОД, ранее достаточно разрозненные.

Как отмечает Александр Ласый, директор департамента автоматизации инженерных систем КРОК, старый советский стандарт на организацию и функционирование машинных залов, претерпевший некоторые изменения в 1985 и 2000 гг., не соответствует потребностям современных технологий и существенно отличается от рекомендаций TIA-942. Требования к инженерной инфраструктуре ЦОД определяются, в частности, потребностью в консолидации ресурсов и приложений, а также в обеспечении соответствия бизнес-процессам и выполняемым задачам. Они касаются кабельных систем, кондиционирования, электропитания, пожаротушения, защиты от протечек, контроля доступа. В их число входят подключение к Internet, территориальным и глобальным сетям, обеспечение круглосуточного режима работы и мониторинга, высокая отказоустойчивость, избыточность (резервирование), безопасность, контроль параметров окружающей среды, возможность быстрого развертывания и изменения конфигурации.

По словам Алексея Солодов-никова, директора по развитию бизнеса APC, в ЦОД насчитывается до 15-16 различных подсистем, включая основное и резервное питание, слаботочную, силовую и иные типы проводки, прецизионные системы кондиционирования и контроля климата, способные поддерживать параметры температуры и влажности в узких пределах, средства пожаробезопасности и физической защиты помещений. На них приходится две трети стоимости крупного ЦОД. Он считает, что по зарубежной статистике можно с точностью до 15-25% оценить стоимость любого российского проекта ЦОД, поскольку при этом применяется практически то же оборудование, а стоимость площадей приближается к мировой. Среди систем распределенной инфраструктуры ЦОД, созданной компанией IBS для ФНС РФ, исполнитель выделяет обеспечивающие системы (систему фальшпола, контроля и управления доступом, вентиляции и кондиционирования, СКС, гарантированного электропитания, газового пожаротушения, охранно-пожарной сигнализации), сетевую и вычислительную инфраструктуры, сеть хранения данных, системы мониторинга, управления и эксплуатации, а также безопасности. Последние две подсистемы «пронизывают» все другие подсистемы ЦОД.

За рубежом в ближайшие три года нужно будет модернизировать примерно 40% ЦОД. Эта сложная задача требует тщательного планирования, ведь 85% простоев, по данным Tivoli Primary Research, связано с изменениями в инфраструктуре ИТ.

В отчете Gartner Data Center Survey отмечено, что причиной 40% незапланированных простоев являются изменения в инфраструктуре ИТ. Свою роль играет и «возраст» ЦОД. По мнению специалистов Intel, центры данных старше восьми лет уже не подлежат модернизации. Стимулом к модернизации служит не только износ ресурсов. Чаще на подобный шаг толкает необходимость увеличения вычислительных мощностей и обеспечения защиты от катастрофических отказов. Однако в целом владельцы ЦОД не спешат с внедрением новых технологий, откладывая их развертывание на перспективу, и предпочитают придерживаться прагматического подхода к решению текущих задач. Тем не менее около четверти менеджеров ЦОД планируют обновить системы в течение трех ближайших лет, и еще около 20% — в текущем году. Исходя из этого, вряд ли стоит делать ставку на неизменность создаваемой инфраструктуры. По данным HP, как правило, ее функционирование рассчитано на пять-десять лет.

Среди наиболее актуальных задач, стоящих перед ЦОД, аналитики TechTarget выделяют защиту данных, сокращение расходов, обеспечение производительности систем и их оптимизацию, резервное копирование и восстановление, рост объемов электронной почты, обоснование затрат на инфраструктуру, ее соответствие требованиям подразделений, модернизацию платформ, рост объемов хранимой информации и сложности управления системами. Результаты прошлогоднего опроса CMP среди специалистов по эксплуатации ЦОД показывают актуальность обеспечения непрерывности бизнес-процессов и масштабируемости. Важными задачами остаются электропитание и охлаждение, причем ежегодно потребность в охлаждении ЦОД растет примерно на 8%. Судя по результатам опроса SYSTIMAX/CommScope (см. Рисунок 1), проблемы кондиционирования и электропитания актуальны для 11% респондентов. С ростом потребления энергии и удельного тепловыделения в ЦОД традиционные технологии все хуже справляются с новыми задачами, поэтому вопросы организации инженерной инфраструктуры становятся более актуальными.

|

| Рисунок 1. Опрос SYSTIMAX Solutions 2005 г. показывает, с какими основными проблемами приходится сталкиваться при реализации ЦОД. |

Зарубежные стандарты ЦОД описывают до 200 различных параметров для четырех категорий центров данных. Заказчики вынуждены учитывать множество аспектов, включая размеры и сроки инвестиций, выбор для ЦОД площадки и технологий и т. д. Один из важных аспектов — уточнение понятия отказоустойчивости. TIA-942 определяет четыре уровня отказоустойчивости ЦОД: базовый (неотказоустойчивый), с резервными компонентами (ЗИП в виде отдельных сменных компонентов), постоянно поддерживаемый (ЗИП в виде заведомо исправных устройств и агрегатов, «холодный» резерв) и отказоустойчивый («горячее» резервирование). ЦОД первого уровня (Tier 1) не имеет резервируемых систем, а потому все плановые и незапланированные работы неминуемо оборачиваются простоями. В ЦОД четвертого уровня (Tier 4) непрерывное функционирование поддерживается автоматически. По оценкам Алексея Солодовникова, центр с полным резервированием обходится в два с половиной раза дороже «простого» ЦОД (см. Рисунок 2).

|

| Рисунок 2. Стоимость 1 мІ ЦОД разного уровня (по данным APC). |

Если ЦОД первого уровня не предусматривает избыточности, то на втором добавляется резервирование основных инженерных систем, но не «путей доставки» сервиса (электроэнергии, каналов сетей передачи данных). Резервирование последних реализуется в ЦОД третьего уровня, что позволяет проводить регламентные работы без его остановки. Четвертый уровень предполагает резервирование (N+1 и выше) всех основных систем и отказоустойчивость при наступлении наихудшего события. Среднее расчетное ежегодное время простоя ЦОД различается от 28,8 ч для первого уровня до 0,8 ч для ЦОД четвертого уровня, а фактически наблюдаемый коэффициент готовности — от 99,67 до 99,99%.

Центры данных призваны обеспечивать бесперебойную работу всех критически важных процессов обработки хранения и передачи информации, однако, по мнению специалистов «Тринити Солюшнс», как недооценка, так и переоценка влияния времени простоя одинаково негативно сказывается на бюджете компании, поскольку финансовые потери возможны в обоих случаях — либо при простое критически важных систем, либо из-за переплаты за решение.

ЦОД первого уровня строились еще во второй половине 60-х гг. Центры данных второго уровня появились в начале 70-х, третий уровень — детище середины 80-х, а ЦОД четвертого уровня впервые был создан в 1994 г. Сегодня ЦОД первого уровня применяются в основном в среднем и малом бизнесе, где ИТ обслуживают в первую очередь внутренние процессы. Кроме того, такими центрами довольствуются компании, которым сайт Internet нужен в качестве пассивного маркетингового средства, или их Internet-бизнес находится на начальном этапе развития. Наивысший, четвертый, уровень характерен для предприятий электронной коммерции, крупных финансовых институтов, интернациональных компаний, у которых сотрудники и заказчики находятся в разных часовых поясах, поскольку постоянный доступ к ресурсам ИТ дает им заметное преимущество и позволяет предоставлять услуги круглосуточно.

Важный параметр — отношение вспомогательных площадей к площади машинного зала, подчеркивают в APC. Если в ЦОД первого и второго уровня оно составляет 20-30%, то на третьем-четвертом уровне увеличивается до 90% и более. Дополнительные площади отводятся под размещение генераторов, холодильных машин (чилеров), электрощитов и другого мощного инженерного оборудования, обеспечивающего работу центра данных. В российских условиях крупный ЦОД второго уровня (как, например, центр М-1 площадью около 2000 мІ) обходится около 7500 долларов/мІ, что примерно соответствует оценкам Uptime Institute. Стоимость ЦОД меньшего размера можно рассчитать, используя поправочные коэффициенты. Сроки реализации проекта и его стоимость не должны сильно отличаться от расчетных.

Стандарты на офисные СКС описывают традиционные тракты и предлагают схемы, которые неприменимы в условиях ЦОД с высокой плотностью портов и насыщенностью оборудования. Например, вместо пользовательских коммуникационных розеток устанавливаются коммутационные панели, к которым подключается оборудование. Такой вариант предусматривает стандарт TIA-942, а применение наборных панелей с розеточными модулями дает возможность получить решение, близкое к стандарту офисных СКС. Грамотно же спроектированная система кабелепроводов позволяет обеспечить гибкость и удобство эксплуатации кабельной системы ЦОД, отмечают в КРОК.

СКС для ЦОД должна предусматривать высокую плотность портов, обладать механической прочностью, помехоустойчивостью, высокой пропускной способностью (с запасом на будущее), обеспечивать гибкость проектных решений и удобство эксплуатации. Увеличение стоимости медных кабелей вследствие роста цен на медь может стать стимулом к появлению более дешевой оптической электроники. В компании «Утилекс АйТи 2000» отмечают, что размещение коммутационных панелей в каждом шкафу с оборудованием заметно увеличивает удобство обслуживания ЦОД, где изменения происходят довольно часто, и позволяет не модернизировать СКС длительное время.

|

| Рисунок 3. Plug-and-Play Universal System компании Corning позволяет быстро смонтировать кабельную систему в ЦОД. |

Несколько производителей СКС и кабельной продукции предлагают специальные решения для центров данных. Олег Востриков, менеджер Corning по продажам в России и СНГ, выделяет в числе требований к кабельной инфраструктуре ЦОД ее эффективность (высокую производительность, надежность и плотность размещения), управляемость (увеличение контроля над инфраструктурой ЦОД), гибкость (высокую скорость и простоту монтажа), масштабируемость. В Corning разработали готовые оптические сборки с увеличенной плотностью соединений (см. Рисунок 3), применение которых позволяет быстро смонтировать кабельную инфраструктуру ЦОД. Для увеличения плотности физических соединений используются соединители MTP на 12 оптических волокон. К основным достоинствам такого оптического «конструктора для ЦОД» в компании относят высокую плотность физических соединений (288 подключений на коммутационную панель высотой 4U), претерминированную заводскую сборку, исключающую ошибки при монтаже, малые вносимые потери, экономию времени монтажа, надежность элементов, масштабируемость и готовность к Ethernet на 10 Гбит/с. Модульная конструкция обеспечивает различные варианты сборок. Правда, подобные решения пока не стали популярными в России (Corning продвигает их в нашей стране с прошлого года).

По словам Ави Коварского, первого вице-президента RiT Technologies, качественная СКС, способная обеспечить бесперебойный доступ к ин-формации и сервисам, — важная часть любого ЦОД. По его мнению, в ЦОД имеет смысл применять систему управления физическим уровнем кабельной инфраструктуры, поскольку это упрощает контроль за коммутацией портов и внесением изменений в физическую конфигурацию сети, позволяя быстро выявлять проблемы. Кроме того, все более значимым для организаций, владеющих как собственными, корпоративными центрами данных, так и коммерческими ЦОД, предоставляющими различные услуги, становится точное документирование соединений. Система управления физическим уровнем сети реализует его автоматически и в реальном времени, в результате упрощаются поиск и устранение неисправностей, а также внесение изменений в СКС и становится возможным принятие информированных решений. В КРОК, спроектировавшей около 90% СКС для распределенных центров данных «Мегафон», уделяют особое внимание тщательности проектирования и документирования СКС. Предварительно осуществляются планирование помещений, анализ потребностей, проектирование сетевой инфраструктуры с учетом резерва, экспертный анализ и согласование с подразделениями.

|

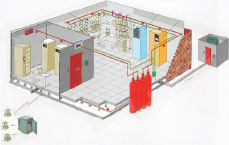

| Рисунок 4. ЦОД — «интеллектуальное здание» в миниатюре. |

В ЦОД используется несколько типов сетей и множество платформ, в связи с чем возникает задача консолидации систем управления. Фактически ЦОД представляет собой «интеллектуальное здание» в миниатюре и содержит все свойственные ему элементы, считает Александр Ласый (см. Рисунок 4). Интеграция различных подсистем ЦОД в общую систему диспетчеризации требует согласования их собственных инструментов управления с системой верхнего уровня. Пока заказчики уделяют этому недостаточно внимания, в результате расширяется парк оборудования с разнородными системами управления, а подсистемами ЦОД обычно занимаются не связанные между собою подразделения. Однако спрос на их интеграцию постепенно растет.

В компании NeuHaus Group, занимающейся как автоматизацией и диспетчеризацией инженерных систем зданий, так и установкой систем гарантированного электроснабжения и климат-контроля, обращают особое внимание на автоматизацию, в том числе мониторинг и управление подачей электроэнергии. Каждый проект требует увязки энергетического и климатического оборудования и создания автоматизированных систем управления компонентами комплексного решения, а в сложных проектах с большим числом взаимоувязанных систем приходится уделять повышенное внимание мониторингу и оповещению оператора. Чтобы свести к минимуму вероятность отказа, используется многократное резервирование систем.

По словам Сергея Авдаляна, руководителя отдела офисных решений службы ИТ «Соник Дуо», в ЦОД необходимы слаженная работа большого количества систем, быстрота и высокое качество диагностики отказов, которые могут возникать в пассивном и активном сетевом оборудовании и программном обеспечении, в частности в результате влияния человеческого фактора.

В реальной интегрированной системе управления инфраструктурой ЦОД приходится анализировать более 200 источников данных и 150 управляющих воздействий, включая контроль распределенных сетей передачи данных, мониторинг кондиционеров и ИБП, активного сетевого оборудования. Для выявления причин отказа наиболее подходит система корреляции событий. Такие системы особенно важны в распределенных ЦОД.

Предлагаемая Rittal система контроля и мониторинга СМС-ТС позволяет контролировать основные параметры ЦОД, включая состояние среды, систем охлаждения, ИБП, обеспечивать контроль доступа и др.

В «Тринити Солюшнс» считают, что решения для комплексного управления инфраструктурой ИТ должны предусматривать контроль всех событий и централизованное управление сетевой инфраструктурой, мониторинг систем, контроль и управление безопасностью. Игорь Романов, начальник службы информационных систем и приложений «Мегафон-Сибирь», выделяет среди используемых в компании систем мониторинга интерактивное отражение состояния всего оборудования, контроль электрической нагрузки, температуры и влажности среды, затопления помещения и открывания дверей, сообщения об авариях, предупреждения об ошибках.

|

| Рисунок 5. Комплексное решение для ЦОД RimatriX5 от Rittal реализует концепцию модульных вычислительных центров и объединяет в себе системы безопасности, охлаждения, источники питания, оборудование для текущего контроля и средства дистанционного управления. |

Системы гарантированного электроснабжения и отвода тепла (прецизионного кондиционирования) - основа функционирования ЦОД. Плотность энергопотребления современных ЦОД выросла многократно - с 5 кВт на стойку до 15-16 кВт (у серверов 1U) или даже 24 кВт (у модульных серверов), а сегодня говорят уже о 80 кВт на стойку. За последние десять лет плотность тепловыделения оборудования возросла в три-пять раз и может доходить до 3 кВт/мІ. Энергопотребление и охлаждение становятся главными проблемами при строительстве ЦОД разного масштаба. Если при мощности в 5 кВт на стойку проблему теплоотвода можно решить традиционными способами, то при более 15 кВт на стойку нужны специальные методы, а отвод тепла от стоек мощностью выше 24 кВт превращается в трудно разрешимую техническую задачу. Это вынуждает производителей переходить с традиционного кондиционирования на локальное охлаждение шкафов и даже жидкостное охлаждение процессоров. Emerson, Rittal, APC предлагают комплексные системы управления электропитанием и охлаждением в ЦОД (включая жидкостное охлаждение), применение которых существенно снижает количество отказов и затраты на сервис (см. Рисунок 5).

В Emerson Network Power подчеркивают, что оборудование должно устанавливаться с учетом требований по климатике с организацией «горячих» и «холодных» коридоров. Доказав свою работоспособность, подобный подход стал общепринятым (см. Рисунок 6) и зафиксирован в руководящих документах ASHRAE с конца 80-х гг.

|

| Рисунок 6. Рекомендации по организации охлаждения в помещениях, где расположено оборудование для обработки данных. |

По словам Виктора Гаврилова, инженера технической поддержки департамента систем прецизионного кондиционирования Emerson, российским проектировщикам ЦОД следует придерживаться рекомендаций зарубежных стандартов по охлаждению и электропитанию, а также руководствоваться паспортными требованиями серверного оборудования.

Непродуманное размещение техники приводит к неправильному распределению воздушных потоков и проблемам с подачей холодного воздуха к стойкам, а неправильное распределение потоков под фальшполом — к перемешиванию горячего и холодного воздуха и рециркуляции воздуха вокруг стоек. Причем в наихудшем случае вблизи кондиционеров решетки фальшпола могут даже забирать воздух из помещения, а не подавать его. В такой ситуации размещение наиболее нагруженного оборудования вблизи кондиционера лишь усугубит проблему. Задача отвода горячего воздуха решается посредством совместного проектирования климатических систем и расстановки оборудования. Как отмечают в «Корпорации ЮНИ», при расположении шкафов задними дверями друг к другу с забором воздушных потоков в кондиционер для охлаждения выбрасываемого в «горячий» коридор воздуха требуется предусмотреть около 3 мІ площади на шкаф.

По словам Алексея Солодовникова, даже при «стандартном» тепловыделении 5 кВт на стойку фальшпол приходится поднимать на высоту 75-90 см. При отводе большего количества тепла требуется увеличить расстояние между стойками и высоту фальшпола (подчас до 1 м и более), что не всегда возможно.

К тому же при рассредоточении оборудования слишком много площади будет пустовать. Другой вариант устранения локальных зон перегрева — установка дополнительных вентиляторов, однако они сами увеличивают энергопотребление и вынуждают наращивать мощность систем кондиционирования, да вдобавок требуют резервирования.

Между тем, по данным Knuerr, оснащение стойки с оборудованием вентиляторами в верхней и нижней панели дает возможность увеличить теплоотвод с 5 до 6-8 кВт на стойку (если позволяет фальшпол). Для оборудования мощностью 5-16 кВт в Emerson рекомендуют систему дополнительных зональных доводчиков, монтируемых, например, на потолке или на стойке. Их можно применять для модернизации ЦОД (без его остановки) при возрастании тепловыделения серверов. Не будучи «привязана» к конкретному оборудованию и не занимая лишнего места, система доводчиков улучшает охлаждение оборудования в верхней части стоек, где наблюдается две трети случаев выхода серверов из строя. По данным Emerson, она способна отводить до 70% тепла, выделяемого в ЦОД. Поскольку в системе применяется фреон, в случае разгерметизации расположенное под нею оборудование не пострадает. Как отмечают специалисты «Корпорации ЮНИ», комбинированные системы воздушно-водяного охлаждения серийно выпускаются несколькими компаниями и потому относительно недороги. Они достаточно компактны и подходят для монтажа в зданиях старой постройки.

Оборудование мощностью свыше 16 кВт на стойку устанавливают в автономные шкафы (42U) с собственной системой кондиционирования и бесперебойного электропитания. В них используют фреоновые кондиционеры, кондиционеры с выносным жидкостным кулером или водяное охлаждение. Предлагаемые Emerson шкафы подобного типа наряду с нужной температурой поддерживают оптимальную влажность воздуха и обеспечивают резервирование системы охлаждения. В случае аварии в электросети система охлаждения шкафа переходит на внутренние ИБП.

Как поясняет Игорь Антин, менеджер Knuerr (ныне входящей в состав Emerson) по развитию бизнеса в Восточной Европе, Финляндии и Прибалтике, в его компании при охлаждении стоек с высоким тепловыделением следуют общему подходу «холод ближе к теплу», т. е. ориентируются на охлаждение самих стоек. Для этого выпускаются, например, специальные дверцы стоек со встроенным теплообменником (Knuerr CoolAdd), подходящие к шкафам большинства известных производителей и позволяющие отводить 8-10 кВт. Еще более мощная система Knuerr CoolTherm с разделением контуров водяного и воздушного охлаждения рассчитана на удаление от шкафа до 35 кВт тепла. Как утверждают в Knuerr, разработанная четыре года назад система CoolTherm дает более 80% экономии площадей ЦОД и примерно на 15-40% сокращает потребление электроэнергии по сравнению с охлаждением всего помещения ЦОД (см. Рисунок 7). Энергоэффективность улучшается на 30%.

|

| Рисунок 7. Система Knuerr CoolTherm с жидкостным охлаждением дает возможность сэкономить примерно 40% инвестиций в ЦОД (по данным производителя). |

Систему жидкостного охлаждения Rittal шириной всего 30 см можно монтировать в боковой части шкафа. Это позволяет использовать все пространство шкафа. Воздушные потоки системы охлаждения направляются горизонтально, поэтому оборудование шкафа охлаждается равномерно. Каждый такой модуль со встроенным микроконтроллером отводит 4-6 кВт тепла. Система Liquid Cooling Package (LCP) предназначена для обслуживания одного или двух шкафов и может подключаться к холодильной установке или водоснабжению (как резервный вариант). По мнению Василия Галагана, руководителя отраслевого направления Rittal, подобный метод обеспечивает лучшее использование площадей ЦОД по сравнению с охлаждением через фальшпол и позволяет отводить до 36 кВт тепла с одного шкафа. При охлаждении самого шкафа нет необходимости организовывать «холодные» и «горячие» коридоры, рассчитывать потоки воздуха, стремиться более эффективно использовать помещение. Системы LCP резервируется по схеме N+1 на нескольких уровнях: с помощью модулей, стоек и на уровне системы обратного охлаждения. Оптимальный подбор температуры входящей воды позволяет избежать конденсата.

По мере развертывания в ЦОД оборудования высокой плотности (например, модульных серверов) проблемы охлаждения будут становиться все более актуальными и для российских заказчиков. По словам Олега Шумаева, архитектора сервисных решений «HP Россия», имеющиеся ЦОД, как правило, проектировались с ограниченным запасом по мощности электропитания и кондиционирования, а эффективность кондиционирования по ряду объективных причин составляет всего 40-50%. Согласно приведенным HP данным, на систему кондиционирования, вентиляции и обогрева (HVAC) приходится до 37% потребляемой ЦОД мощности (см. Рисунок 8). В отдельных случаях HVAC потребляет более 50% мощности ЦОД. Эффективным же считается показатель менее 30%.

|

| Рисунок 8. Распределение потребляемой ЦОД мощности по различным системам (по информации HP). |

Для повышения эффективности систем охлаждения и определения безопасных (с учетом аварийных ситуаций) режимов работы оборудования специалисты HP рекомендуют провести термический анализ ЦОД. Он помогает установить экономическую целесообразность применения конкретных вариантов систем вентиляции и охлаждения, ведь увеличение мощности кондиционирования — это дополнительные расходы. Кроме того, в шкафах нередко комбинируется различное оборудование с различающимися требованиями по охлаждению, а сам ЦОД, не будучи статичной системой, предусматривает добавление нового оборудования или замену существующего.

Специальное ПО, которое выпускает HP, выполняет численное моделирование полей температуры, потоков, давления воздуха во всем объеме ЦОД, исходя из реальной геометрии помещения и имеющегося оборудования с учетом положений проекта относительно штатных и аварийных режимов, по результатам которых предоставляются рекомендации. Такое моделирование имеет более высокую точность (90-94%), чем интуитивный подход, не зависит от производителя оборудования, применимо к построенным или проектируемым ЦОД, помогает разрешать существующие и предотвращать будущие проблемы. Специальное ПО для расчета и выбора подходящего типа охлаждения в зависимости от задачи используют и в Rittal.

Как многофакторная система, ЦОД требует сбалансированного энергообеспечения. Непрерывное электропитание — одно из самых важных условий его функционирования. В КРОК подходящей основой для создания отказоустойчивых систем электроснабжения ЦОД считают мощные модульные ИБП с двойным преобразованием. Такие решения, как правило, предусматривают установку систем управления и мониторинга. Согласно статистике КРОК, внедрение ИБП позволяет за счет высокого качества электропитания примерно на 30% снизить число отказов серверов и на 50% — отказов комплектующих. По данным APC, благодаря резервированию по электропитанию и охлаждению удается сократить простои с 22 до 1,2 ч в год, хотя подобный вариант существенно дороже. Одна из тенденций — создание модульных, гибких и масштабируемых систем охлаждения и электропитания.

В требованиях по электропитанию приходится учитывать и будущее расширение парка оборудования. Андрей Павлов, генеральный директор компании DataDome, считает необходимым заранее планировать возможность масштабирования ЦОД без прерывания его работы. Методика расчета перспективного масштабирования ЦОД включает прогноз энергопотребления исходя из площади ЦОД (до 2,5 кВт/мІ для традиционной схемы холодоснабжения), проектирование ИБП с запасом до 20% в целях масштабирования, а также размещение дизель-генераторов с первоначальной загрузкой не менее 30% от мощности.

Предлагаемые Rittal системы энергообеспечения и электрораспределения, включая системы бесперебойного питания, можно наращивать. Например, электрораспределение в рамках отдельных стоек и ЦОД основывается на патентованной технологии, благодаря которой систему можно расширять без прерывания работы ЦОД. Она предусматривает дублированный подвод электропитания и позволяет обслуживать до 32 стоек — по 10 кВт на каждую.

Традиционные методы увеличения надежности системы электроснабжения ЦОД — резервирование ИБП и установка дизель-генераторов (ДГУ). Однако, как отмечают в DataDome, при этом нередко упускается из виду необходимость устранения критических точек отказа и резервирования кабельных линий с вводом по разным трассам. Кроме того, часто заказчик пытается избежать хлопотной установки ДГУ в пользу более мощных ИБП, однако ИБП, обладающий ресурсами на 1-2 ч автономной работы, не заменит систему ИБП в сочетании с ДГУ. По оценкам DataDome, стоимость решения из ИБП и ДГУ всегда ниже, чем ИБП с большим количеством батарей, между тем как надежность ЦОД заметно повышается.

Как считают в NeuHaus Group, системы гарантированного электроснабжения становятся более сложными и разнообразными, однако единого подхода быть не может — решения должны создаваться в соответствии с требованиями и задачами конкретного заказчика.

Не менее важная задача — защита данных. По словам Станислава Заржецкого, регионального менеджера компании Lampertz, входящей, наряду с Rittal, в международную группу компаний Friedhelm Loh Group и предлагающей решения по физической защите информационных ресурсов, функциональная безопасность ЦОД включает в себя техническую безопасность (надежность оборудования), логическую (определяемую качеством ПО) и физическую защиту от разнообразных внешних факторов, будь то вандализм, огонь, вода, скачки напряжения, электромагнитные помехи, несанкционированный доступ и т. д. По данным Lampertz, 35% менеджеров считают допустимым (не критичным для бизнеса) время простоя систем до 3 ч, а 24% — 3-8 ч, между тем как для 22% специалистов простои кажутся совершенно недопустимыми.

Lampertz создает ЦОД «под ключ» на основе «комнат безопасности» различных типов и классов защиты от всех типов физического воздействия — от базового до полного. Их модульная конструкция адаптируется к структуре здания и создается «под заказчика», а инфраструктурные составляющие включают кондиционирование, ИБП, обнаружение и тушение огня, мониторинг, двери и фальшполы (см. Рисунок 9).

|

| Рисунок 9. Решения Lampertz предусматривают создание ЦОД на основе модульных «комнат безопасности» различных типов в зависимости от критичности времени простоя. |

В компании подчеркивают, что при оценке ситуации в области безопасности нужно учитывать различные потенциальные риски для инфраструктуры ИТ и степень зависимости бизнеса от надежности ее работы, на основании которых следует просчитать, сколько дней (часов или минут) сможет проработать предприятие в случае остановки всех систем. Это позволяет определить, в какой мере необходима физическая защита ресурсов ИТ. Как отметил Станислав Заржецкий, на основе стандарта Евросоюза по безопасности информационных помещений EN 1047-2 готовится соответствующий российский ГОСТ, появление которого ожидают в ближайшее время.

В Lampertz не используют подачу воды в ЦОД для систем охлаждения. Между тем Андрей Павлов считает, что системы с водяным охлаждением по сравнению с аналогичными решениями на фреоне подчас дешевле и в инсталляции, и тем более в эксплуа-тации.

Физическая безопасность — это не только защита от затопления, пожара, землетрясения, но и предупреждение несанкционированного доступа. По всему миру каждый год компании теряют огромные средства от преднамеренного нанесения вреда системам ИТ. Вопросы ограничения физического доступа актуальны и для России. В КРОК к числу жизненно важных систем ЦОД относят систему пожаробезопасности, защиты от протечек и управления доступом в помещения.

Сергей Логинов, управляющий директор Reiche&De Massari в России, полагает, что нужно обращать особое внимание на «человеческий фактор», подчас приводящий к катастрофическим последствиям, и считает защиту кабельной инфраструктуры ЦОД частью общей концепции безопасности. В R&M к составным факторам безопасности СКС относят надежность оборудования, его износостойкость, устойчивость к окружающей среде и ошибкам персонала. В стандарте TIA-942 эти моменты отражены в недостаточной степени — он описывает лишь некоторые аспекты применения СКС с точки зрения электромагнитной совместимости.

По данным R&M, предотвращение сбоев СКС на 44% зависит от предсказуемых параметров кабельной системы в условиях реальной эксплуатации, 32% — от эффективных мер по защите от неверных подключений и отключений (человеческий фактор) и лишь 3% — от электромагнитной устойчивости. Чтобы предотвратить ошибки персонала, в R&M разработали трехуровневую защиту физических соединений средствами СКС: цветовое кодирование шнуров и розеток (для визуальной идентификации подключений), предохранение от неверных подключений (механическая блокировка) и отключений (блокировка нажатия язычка соединителя RJ-45). Для извлечения коммутационного шнура в СКС R&M требуется специальный ключ или поворот клипсы.

Если в R&M эти проблемы решают на физическом уровне, то RiT использует ПО, входящее в состав системы управления кабельной инфраструктурой. Ави Коварский также считает защиту физических и логических соединений важной задачей для ЦОД из-за непредсказуемости влияния человеческого фактора. Отслеживание изменений в сети в реальном времени в системе RiT PatchView предлагается как один из составных элементов физической, сетевой и информационной безопасности.

Для обеспечения безопасности необходимы также четкое разделение ответственности за состояние отдельных систем и установка систем мониторинга и видеонаблюдения, которые в составе своих комплексных решений предлагают многие производители.

Современный ЦОД — многофакторный проект, и обычно проектировщики исходят из целесообразности и стоимости реализации тех или иных функций. В презентациях IBS, IntelinePro, DataDome, «Утилекс АйТи 2000» были показаны примеры строительства, развертывания и эксплуатации ЦОД, опыт которых позволяет извлечь некоторые уроки из типичных ошибок.

При строительстве ЦОД необходимо определиться с целью и требованиями (от них зависит его инфраструктура и ход реализации проекта), провести внутренний аудит ресурсов ИТ, рассмотреть варианты реализации, создать прототип и выполнить тестирование, по результатам которых уточнить требования к ЦОД, разработать технический проект, выбрать будущую организационную структуру ЦОД, подготовить помещения, закупить оборудование и ПО, провести установку и настройку, испытания и перевод в опытную эксплуатацию, осуществить доработки и ввод в промышленную эксплуатацию. Здесь важно соблюдать продолжительность и последовательность каждого этапа, согласование технических требований и условий.

По мнению Сергея Ошерова, системного архитектора IBS, факторами успеха проектов ЦОД являются четкие цели и технические требования, тесное сотрудничество грамотного заказчика и опытного исполнителя. При реализации IBS в 2005 г. проекта распределенного ЦОД для ФНС, объединявший пять региональных центров данных, в состав проектной команды были включены специалисты заказчика и исполнителя, к участию в работе были привлечены большое количество партнеров и представители поставщиков. План-график работ состоял из 340 пунктов.

В управляющей компании IntelinePro считают самой важной предпроектную часть. На этом этапе проще всего решить проблемы, которые иначе могли бы возникнуть в будущем. В Emerson отмечают, что согласование на начальных этапах, в том числе со службой эксплуатации, помогает избежать ошибок еще на старте. Использование существующих помещений требует учета большого количества критериев при выборе площадки, включая привязку к имеющейся планировке, обследование строительных конструкций и инженерных систем. Найти площадку, отвечающую всем требованиям, практически невозможно — здесь неизбежны компромиссы, подчеркивают в IntelinePro.

Руслан Арсланов, руководитель отдела кабельных систем компании «Утилекс АйТи 2000», напоминает, что выбираемое для ЦОД помещение должно соответствовать его инфраструктуре (а не наоборот), иметь как минимум достаточную для оптимального размещения оборудования площадь, обеспечивать несущую способность перекрытий и гарантированное электроснабжение в соответствии с нормами. Дополнительное преимущество дают транспортная доступность и наличие офисных помещений. Строительство ЦОД — сложный и продолжительный проект, однако тесное взаимодействие с подразделениями заказчика позволяет оптимизировать его сроки и стоимость.

Игорь Романов также называет в числе требований к зданию и помещению для ЦОД несущие характеристики перекрытия здания, разрешенную для него электрическую мощность, высоту помещения, возможность установки фальшпола и подвесного потолка, запас площадей для расширения ЦОД, возможность размещения дизель-генератора, электрощитовой, рабочих мест обслуживающего персонала и устройств для пожаротушения, наличие воды и канализации для систем климатического контроля. Александр Мартынюк, технический директор IntelinePro, выделяет девять этапов формирования требований к помещениям ЦОД: подбор площадки, предварительный дизайн помещений, подготовку требований к техническим параметрам и к выбору подрядчиков, проведение конкурса, проектирование, поставку оборудования, тестовую эксплуатацию и приемосдаточные испытания, организацию сервисной службы.

Зонирование ЦОД в зависимости от типа размещаемого оборудования влияет не только на специфику подводящих кабелей. По словам Андрея Павлова, проектирование системы пожаротушения для отдельных зон ЦОД обходится в несколько раз дешевле, поскольку для борьбы с огнем в ограниченной зоне можно использовать менее мощную систему. При строительстве ЦОД приходится учитывать нормы международных стандартов, корпоративные требования заказчика и опыт эксплуатации центров данных. Обычно в проекте задействуются несколько подрядчиков по отдельным системам и управляющая компания. Последней приходится вести большой объем документации и решать все тактические задачи.

По мнению Сергея Авдаляна, внедрение грамотно спроектированных инженерных систем способно значительно повысить надежность ЦОД. Снижение отказов систем из-за «простых» причин дает возможность сосредоточиться на сложных вопросах, уменьшает время диагностики неисправностей, количество инцидентов и проблем. Как следствие, сокращаются расходы на обслуживание, снижается вероятность потери данных, повышается качество предоставления сервиса, увеличивается срок эксплуатации серверов и устройств, предназначенных для оснащения рабочих мест.

По словам Дмитрия Ткачева, руководителя отдела проектирования компании BCC, заказчикам ЦОД следует быть более внимательными в стремлении сэкономить на инженерных системах, поскольку дешевизна решения обычно означает снижение качества, надежности, и, как следствие, уменьшение жизненного цикла инфраструктуры ЦОД, составляющего 8-15 лет, что в два с половиной-три раза больше жизненного цикла оборудования ИТ. При правильно построенной качественной инженерной инфраструктуре ЦОД смена линейки быстро устаревающего оборудования ИТ не потребует новых затрат на развитие инженерных систем — они переживут два-три жизненных цикла оборудования ИТ.

Изменения в технологиях и оборудовании влекут за собой ужесточение требований к инженерной инфраструктуре. При подготовке ТЗ по первичному запросу можно воспользоваться данными моделирования в имеющихся у крупных интеграторов центрах компетенции. Хотя опыт исполнителей и грамотность заказчиков растут, последних нередко приходится убеждать рационально подходить к реализации тех или иных функций с учетом их стоимости. С увеличением количества проектов будет накапливаться и опыт их внедрения.

За рубежом существуют организации, объединяющие профессионалов, работающих в области центров данных, например Institute for Data Center Professionals (IDCP), разрабатываются стандарты, описывающие требования к инфраструктуре ЦОД, накоплена обширная статистика. В России проектов ЦОД еще слишком мало, чтобы делать обобщения, однако можно использовать зарубежный опыт и расчеты таких организаций, как Uptime Institute. Тематические конференции позволяют их участникам познакомиться с достижениями в этой сфере, вариантами реализации ЦОД с учетом специфики деятельности предприятий и решаемых задач, практическими примерами их развертывания и эксплуатации.

Сергей Орлов — обозреватель «Журнала сетевых решений/LAN». С ним можно связаться по адресу: [email protected].